阿里巴巴Qwen 团队发布新模型,数学推理更进一步

CBINEWS

责任编辑:张琳

电脑商情在线

时间:2025-01-16 12:34

阿里巴巴 Qwen 大模型

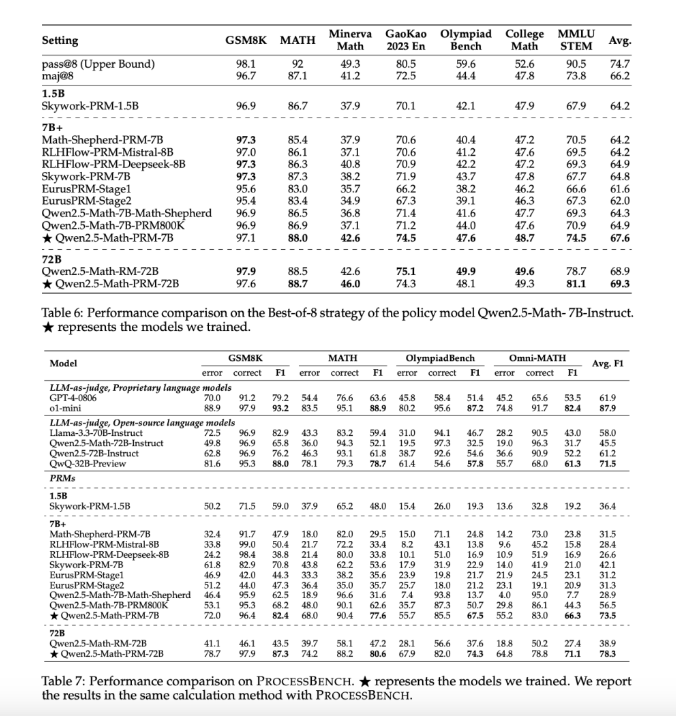

近期,阿里巴巴 Qwen 研究团队发布了题为《数学推理中过程奖励模型的开发经验教训》的学术论文,并推出了 Qwen2.5-Math-PRM 系列中的两款新模型,分别具备7B 和72B 参数。这些模型在数学推理领域突破了现有 PRM 框架的局限,通过创新技术显著提升了推理模型的精确度和泛化能力。

数学推理长期以来是大型语言模型(LLM)所面临的重大挑战,尤其是在推理过程中的中间步骤,错误往往会对最终结果的准确性产生负面影响,这对于教育、科学计算等对精确度要求极高的领域尤为关键。传统的评估方法,如 Best-of-N(BoN)策略,无法充分捕捉推理过程的复杂性,因此,过程奖励模型(PRM)应运而生,旨在通过评估中间步骤的正确性来提供更细致的监督。

然而,构建高效的 PRM 面临数据注释和评估方法上的挑战,这也是现有模型无法完全解决的难题。因此,需要一种更符合稳健、过程驱动推理的模型。

Qwen 研究团队的创新方法结合了蒙特卡洛(MC)估计和“LLM 作为判断”的机制。该混合方法提高了分步注释的质量,使得 PRM 能够更有效地识别并减轻数学推理中的错误。通过这一技术,Qwen2.5-Math-PRM 系列的模型在 PROCESSBENCH 等基准测试中表现出色,特别是在找出中间推理错误的能力上。

共识过滤:仅当 MC 估计和 LLM 作为判断者都同意步骤正确性时,才保留数据,从而显著减少训练中的噪音。硬标记:经过双重机制验证的确定性标签增强了模型区分有效和无效推理步骤的能力。高效数据利用:将 MC 估计与 LLM 作为判断相结合的共识过滤策略,确保了高质量的数据,并保持了可扩展性。

这些创新帮助 Qwen2.5-Math-PRM 模型不仅提高了准确性,还增强了其在自动辅导和复杂问题解决等应用中的表现。

Qwen2.5-Math-PRM 系列在多个评估指标上表现优异。例如,Qwen2.5-Math-PRM-72B 模型的 F1得分高达78.3%,超过了许多开源替代品。特别是在需要逐步识别错误的任务中,它的表现优于 GPT-4-0806等专有模型。

共识过滤机制有效降低了数据噪声约60%,显著提高了训练数据的质量。此外,Qwen2.5-Math-PRM 强调分步评估,而非传统的基于结果的 BoN 策略,这解决了早期模型通常过于依赖最终答案而忽视推理准确性的问题。

Qwen2.5-Math-PRM 系列的推出标志着数学推理领域的重大进步。通过解决 PRM 开发中的难题,如数据注释的噪声和过程到结果的偏差,Qwen 研究团队提供了一个提高推理准确性和可靠性的实用框架。随着该技术的不断发展,预计未来 PRM 模型将在更广泛的 AI 应用中发挥重要作用,提升机器推理系统的可靠性和有效性。