英伟达Dynamo:AI工厂的“操作系统”

CBINEWS

责任编辑:邹大斌

电脑商情在线

时间:2025-03-25 10:18

GPU 英伟达 AI AI工厂

在上周英伟达的GTC大会上,最受关注的无疑是Blackwell Ultra以及即将推出的Vera和Rubin系列CPU。相比较而言,Dynamo的关注度明显低了很多。实际上,这个名为Dynamo的软件同样值得关注。在GTC大会上发布的Dynamo被首席执行官黄仁勋称为“AI工厂的操作系统”,并被比作引发工业革命的发电机。“发电机是开启上一次工业革命的第一台仪器,”首席执行官表示,“能源工业革命——油进入,电出来。”

因为这个开源推理套件可以更好地优化诸如TensorRT LLM、SGLang和vLLM等推理引擎,使其能够在大量GPU上尽可能快速高效地运行,帮助模型中更快更便宜地生成一个接一个的token,让用户体验更好。

推理比看起来更难

在高层次上,大型语言模型的输出性能可以分为两大类:预填充(Prefile)和解码(Decode)。预填充的快慢由GPU的浮点矩阵数学加速器处理输入提示的速度决定。提示越长——比如摘要任务——这通常需要更长时间。

另一方面,解码是大多数人与大型语言模型性能相关联的部分,相当于GPU对用户提示做出响应并生成实际token的速度。

只要GPU有足够的内存来容纳模型,解码性能通常取决于内存的速度和你正在生成的token数量。具有8TB/s内存带宽的GPU生成token的速度将比3.35TB/s的GPU快两倍多。

当开始为更多人提供更大的模型并处理更长的输入和输出序列时,事情会变得复杂,就像在AI研究助手或推理模型中看到的那样。

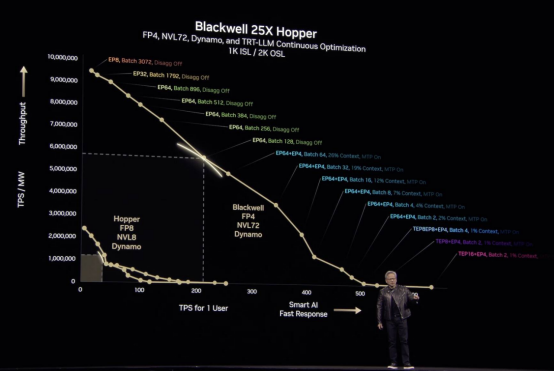

大型模型通常分布在多个GPU上,而实现这一点的方式对性能和吞吐量有重大影响,这是黄仁勋在主题演讲中详细讨论的内容。

“我们有数百万个我们可以配置数据中心的点,我们可以通过多种方式并行化、拆分和分片工作,”他说。

从英伟达首席执行官黄仁勋的主题演讲幻灯片中可以看出,推理性能会因模型的分布式处理方式而产生很大差异。该图表以每秒生成的token数为一个用户和每兆瓦每秒token数的总体值进行对比……

他的意思是,根据模型的并行化方式,你可能能够为数百万并发用户提供服务,但每个用户每秒只有10个token。而另一种组合可能只能处理几千个并发请求,但能在瞬间生成数百个token。

黄仁勋表示,如果你能确定在这一曲线上工作负载在提供理想个体性能的同时实现最大吞吐量的位置,你就能为服务收取溢价,同时降低运营成本。我们想象这至少是部分大型语言模型提供商在将生成式应用和服务扩展到更多客户时所进行的权衡。

找到性能和吞吐量之间的平衡点

找到性能和吞吐量之间的平衡点是Dynamo提供的关键功能之一。

除了为用户提供关于专家并行、管道并行或张量并行的理想组合外,Dynamo还将预填充和解码分离到不同的加速器上。

英伟达表示,使用Dynamo的GPU规划器根据需求确定应该将多少加速器用于预填充和解码。

然而,Dynamo不仅仅是一个GPU分析器。该框架还包括提示路由功能,识别并引导重叠请求到特定的GPU组,以最大化键值(KV)缓存命中的可能性。

如果你不熟悉,KV缓存代表模型在任何给定时间的状态。因此,如果多个用户在短时间内提出类似问题,模型可以从缓存中提取数据,而无需反复重新计算模型状态。

除了智能路由器外,Dynamo还具备低延迟通信库,以加速GPU之间的数据流动,以及内存管理子系统,负责在HBM与系统内存或冷存储之间推送或拉取KV缓存数据,以最大化响应速度并最小化等待时间。

对于运行Llama模型的Hopper架构系统,英伟达声称Dynamo可以有效使推理性能翻倍。而对于较大的Blackwell NVL72系统,GPU巨头声称在启用该框架的情况下,DeepSeek-R1相比Hopper具有30倍的优势。

兼容Ampere和Hopper

虽然Dynamo显然针对英伟达的硬件和软件堆栈进行了优化,但与它所取代的Triton推理服务器类似,该框架旨在与流行的模型服务软件库集成,如vLLM、PyTorch和SGLang。

这意味着,如果你正在使用一个异构计算环境,其中除了英伟达GPU外还包含大量AMD或英特尔加速器,你无需再认证和维护另一个推理引擎,而是可以继续使用vLLM或SGLang,如果这正是你已经在使用的。

显然,Dynamo不会与AMD或英特尔硬件兼容,但它可以在任何英伟达GPU上运行,比如Ampere架构。因此,如果你仍在使用大量A100 GPU,你仍然可以从英伟达的新AI操作系统中受益。

英伟达已经在GitHub上发布了Dynamo的启动和运行说明,并将提供该框架作为容器镜像——或者他们称之为NIM——以便于部署。