谷歌推出第七代 TPU

CBINEWS

责任编辑:邹大斌

电脑商情在线

时间:2025-04-10 10:34

谷歌 TPU AI LLM

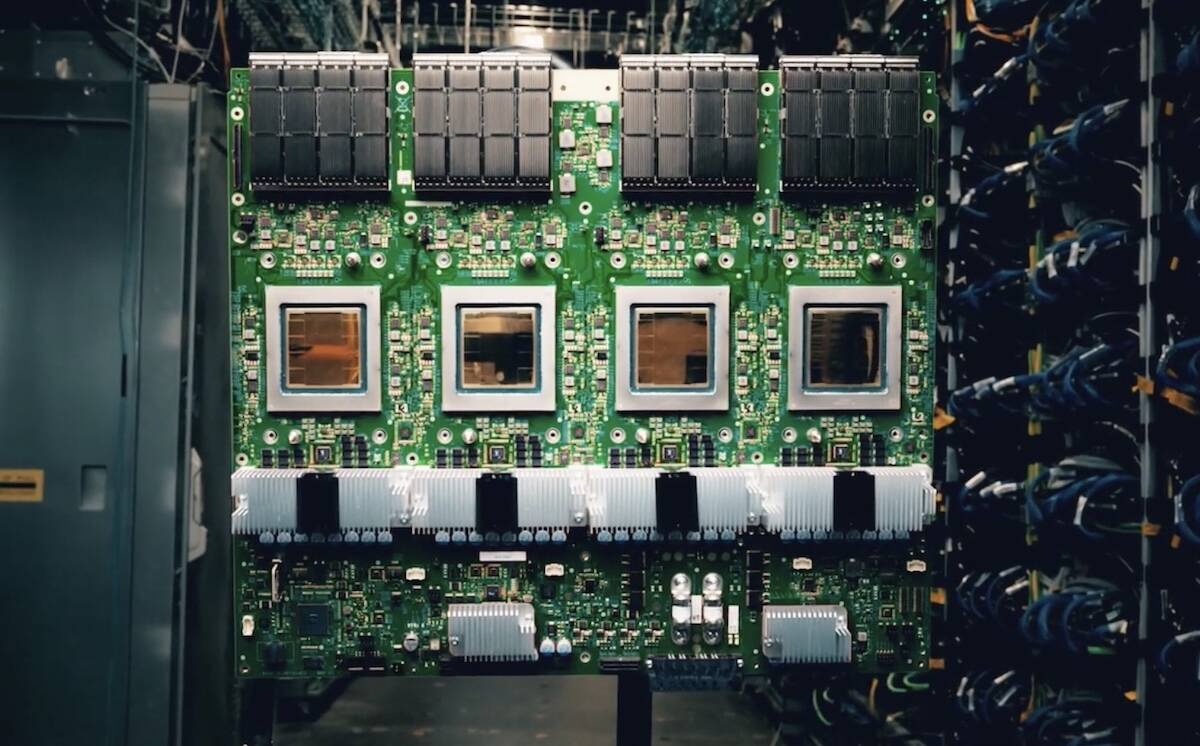

谷歌在周三召开的Cloud Next大会宣布,第七代TPU(张量处理单元)即将对客户开放,以 256 或 9216 芯片的集群形式提供。

谷歌称,一个配备 9216 个自研 AI 加速器的集群将提供比全球排名第一的已知超级计算机——美国的“El Capitan”——高出 24 倍的计算能力,达到 42.5 exaFLOPS,而后者仅为 1.7。

尽管这听起来令人印象深刻,但有一点需要知道。42.5 exaFLOPS 的峰值性能是基于 FP8 精度,而 El Cap 在以 HPC 为中心的 LINPACK 基准测试中,以 FP64 达到了 1.74 exaFLOPS。其理论峰值性能实际上接近 2.74 FP64 exaFLOPS。

如果将 El Cap 的性能归一化到 FP8,基于 AMD 的 HPE-Cray 超级计算机的理论峰值性能在密集工作负载下约为 87 exaFLOPS,而在稀疏工作负载下则翻倍。谷歌将 42.5 exaFLOPS 的 FP8 与 1.74 exaFLOPS 的 FP64 进行对比,而实际上应该是 42.5 对比至少 87,这意味着 El Capitan 轻松胜过一个 9216 TPU v7 集群。因此,24 倍的说法值得商榷。

抛开这些对比不谈,谷歌最新的代号为Ironwood 的TPU相比去年的 Trillium 系列有了重大升级。其专为大型语言模型(LLM)推理设计,每个 TPU 配备高达 192 GB 的高带宽内存(HBM),带宽在 7.2 TB/s 到 7.4 TB/s 之间。

众所周知,内存带宽是推理工作负载的主要瓶颈。更大的内存容量意味着芯片可以容纳更大的模型。在浮点性能方面,谷歌宣称每个水冷 TPU v7 可以输出 4.6 petaFLOPS 的密集 FP8 性能,这使其性能与英伟达的 Blackwell B200 处于同一水平。

除了TPU外,Ironwood 还配备了谷歌的 SparseCore,旨在加速在排名和推荐系统中常见的“超大型嵌入”。这些芯片预计将于今年晚些时候全面上市。

为了构建这些集群,每个 TPU 配备了一种专用的芯片间互连(ICI),谷歌称其双向每链路带宽为 1.2 terabits 每秒,比 Trillium 提升了 1.5 倍。

根据谷歌的说法,较大的集群在满载时将消耗大约 10 兆瓦的电力。谷歌没有说明单芯片的 TDP,但这表明它在类似级别 GPU 观察到的 700 瓦到 1 千瓦范围内。虽然这听起来像是很大的功耗,但谷歌强调,这些芯片仍比 2015 年推出的首批 TPU 高出 30 倍的效率,并且比去年的芯片提供两倍的性能功耗比。